Camera

Camera 相机

- 透镜(小孔) 成像的关键

- 快门 一般一直处于关闭状态,直到按下拍照的瞬间才会打开,允许光线信息进入到透镜

- 传感器 存储光线信息,传感器的每一点记录了来自物体所有方向的光,因此每一点存储的也就是irradiance

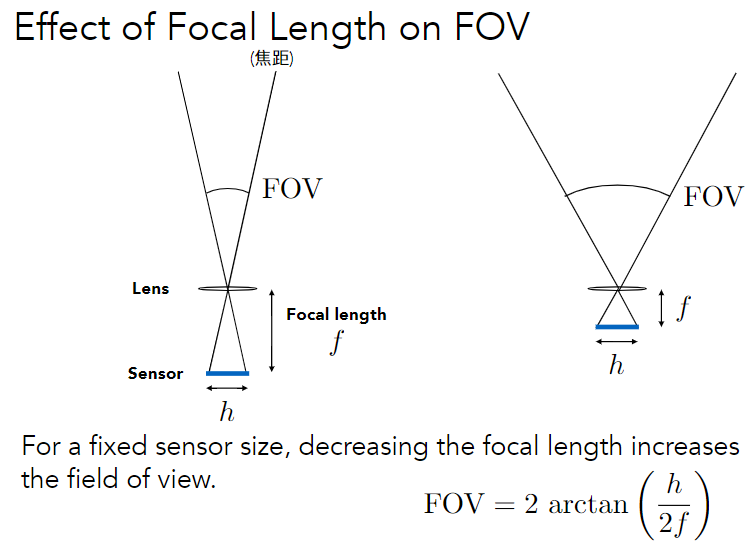

Pinhole Image Formation 小孔成像与视场(FOV)

焦距f越小的时候FOV的角度也就越大,自然可以成像出更大的范围 底片长度越大,自然FOV也就越大

手机相机说的焦距都是相对而言 经过一定比例缩放的

Exposure 曝光

传感器上接受到的是irradiance(每单位面积所接受到的光线功率) 曝光就是用时间乘上了这个irradiance 即真正的所接受到的能量(Energy)

Exposure = time x irradiance $\qquad$ H = E x T

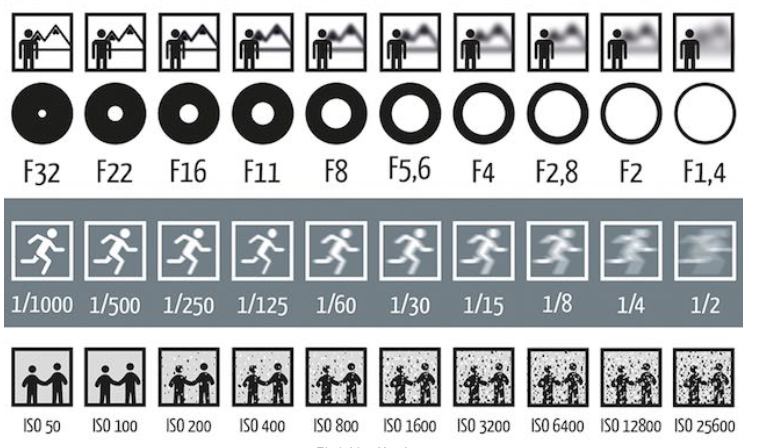

曝光受参数的影响

- 快门速度(Shutter speed),快门打开时间越长,进光时间越长,进光量自然越多

- 光圈大小(Aperture size),描述此项的数值称为f-stop,直观理解如果光圈越大,被遮挡的光越少,进光量越多,那么曝光的程度就会越高

- 感光度(ISO gain),对于感光度可以简单理解为对最终的图像值乘上了一个倍数

ISO的值显著增大之后,虽然画面整体亮度会提升,但同时也会观察到画面有很多的噪点

快门速度值越大代表速度越慢,快门打开时间越长,透镜的进光量越大,图片也就会越亮,但同时运动的物体也会变的模糊起来 (动态模糊) 无论快门打开的速度有多快,它一定有一个打开关闭的过程

游戏内每一帧都是静止画面并不存在动态模糊 所以往往需要60FPS以上

光圈大小 F-stop 或者F-Number值(该行中的逗号代表小数点),该值大小与光圈直径的倒数成正比,因此FN值越小,代表光圈越大,进光量越大,画面亮度越高,但同时也会带来景深模糊的影响

应用: 高速摄影(补偿进光时间不够 小的快门速度 大光圈或提高ISO)和低速摄影

详情: https://zhuanlan.zhihu.com/p/134166476

Depth of Field 景深

透镜

- 所有平行射入透镜的光都会集中于一点,称该点为焦点

- 所有从焦点射入透镜的光都会平行射出(光路可逆性)

- 焦距可以被随意改变(单个透镜当然不行,但在现实中大部分的照相机都是一个透镜组,可以做到焦距随意改变)

成像规律 $\frac{1}{f} = \frac{1}{z_i} + \frac{1}{z_o}\qquad z_o和z_i为物距像距$

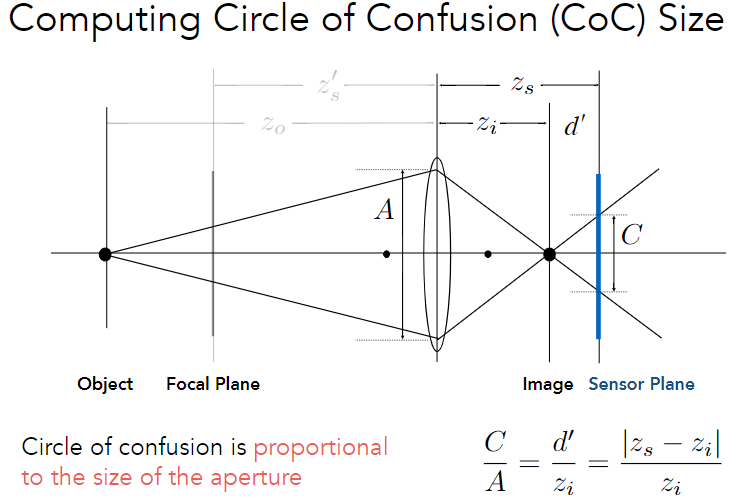

景深模糊 Defocus Blur

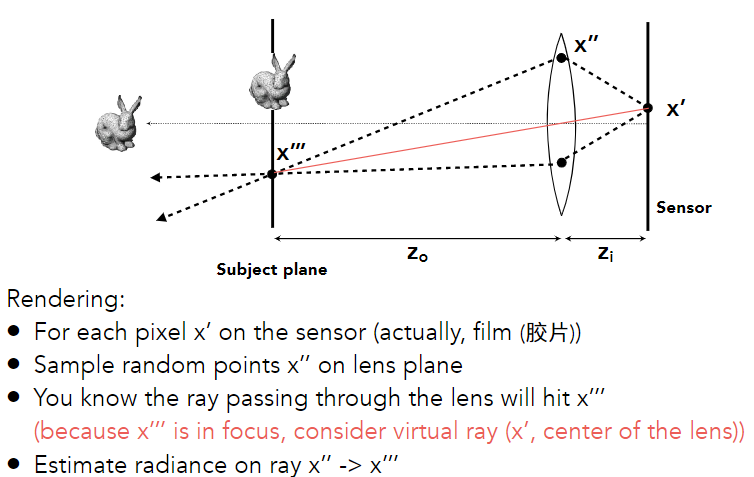

当一个传感器平面不在一个物体真正精确的成像平面之上时(即之前所提到到像距zi的平面),便会出现模糊 点变成了圆 长度C称为 Circle of Confusion

C与透镜长度A成正比,而透镜长度也与光圈的直径成正比,因此当光圈越大,C也就越大,此时出现的景深模糊也就越明显

光圈大小F-Number具体来说N = f/D 焦距比上直径

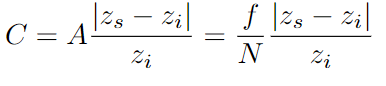

光线追踪当中实现景深模糊 简单的模拟透镜的光线传播

确定薄透镜的大小和位置,由此确定光圈和焦距,然后在透镜和传感器(像素屏幕)上分别采样,并连接成一条线

这条光线经过折射后偏转,打到物体的x’’’处,计算x’’’到x’’的radiance并记录在x’处,这就是一条光追路径的薄透镜近似流程

- Depth of Field 景深

景深模糊是一种情形,而景深则是一个具体的数值

当我们固定一个可以接受的Circle of Confusion C值之后,可以逆向推导出小于该C值的对应的一段距离是多少,这个距离就是景深

Light Field / Lumigraph 光场

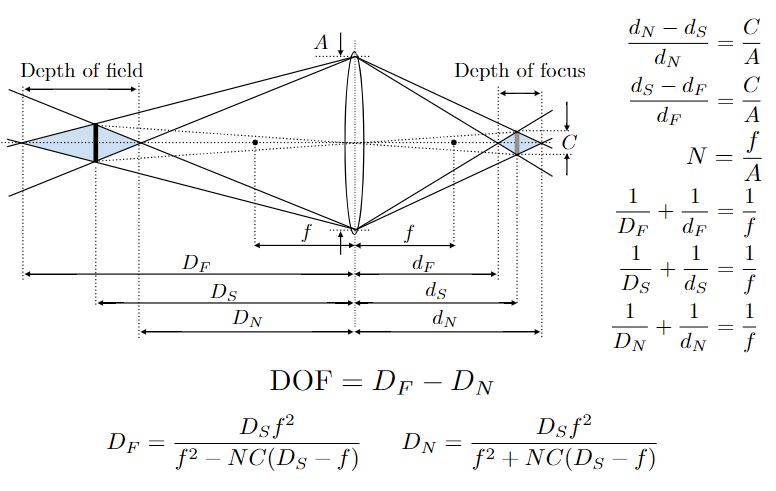

The Plenoptic Function 全光函数

记录光线特征信息的函数,一般来说这些特征被分为四类:位置,角度,波长,时间

Sampling Plenoptic Function

光场,就是对全光函数的采样,可以理解为全光函数的一个子集 现实中光线的颜色特征通常由RGB通道记录,而时间信息通常由动画帧来记录

对于光场来说只需要关注方向和位置 七维的信息就被降至为了五维

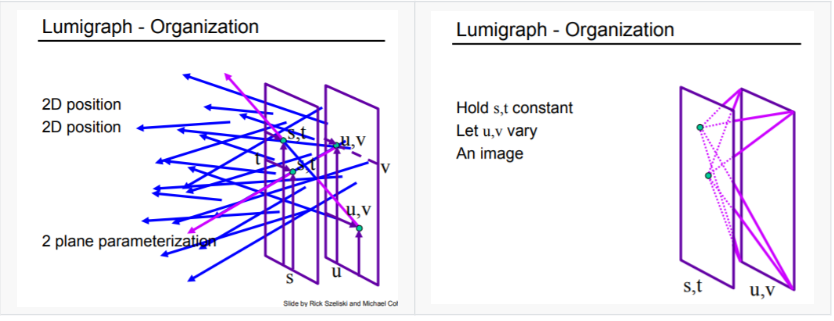

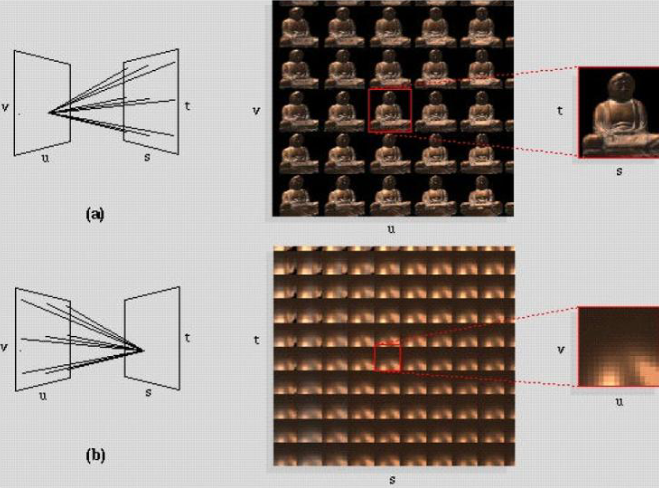

后来发现只需要四维的信息(二维位置信息uv + 二维方向信息θφ)就可以定义光线的方向和位置

再后来,直接定义两个平面,两平面上任意两点连线就可以表示空间中任意一条光线

光场其实就是不同时间,不同地点处的描述光的物理量

而这些物理量需要根据你的着重点的不同而适当做出调整

对相机来说,uv可以理解为传感器/成像平面,st可以理解为镜头/光圈平面

用采样来理解:

- 固定(u,v),对st平面采样,此时的采样结果可以理解为从uv上某点沿各个方向观察世界的结果

固定(s,t),对uv平面采样,此时的采样结果可以理解为从uv上各个不同的点以不同角度观察世界中某一点的结果

自然界中苍蝇的复眼也是用类似的方式来感知外界信息的,也就是说苍蝇所接受到的信息不是Irradiance,而是经过复眼分光的Radiance信息

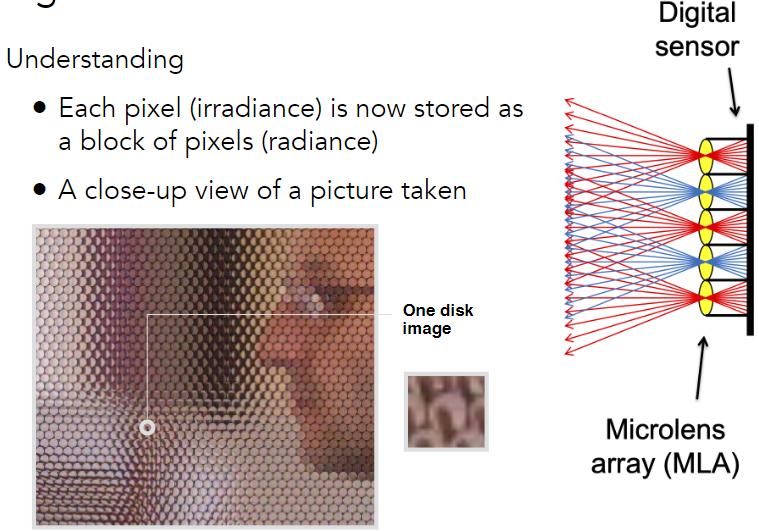

Light Field Camera 光场相机

能记录光场的相机,它最重要的功能在于它支持先拍照,然后在后期重新对焦

将原本的成像面的每个像素都换成微透镜(相当于st),再在成像面后面真正的去使用传感器记录信息(相当于uv)

普通相机的传感器像素记录的是irradiance,但是对于光场相机来说,它们记录的分光之后的分量,也就是记录的是Radiance

对于每个微透镜,在经过它的光线中只选择一条,这样每个微透镜就都对应了一个值,然后把这个值作为当前传感器像素的值

可以统一选择最下面的光线,也可以选择中间那根,这样就可以实现虚拟的移动相机的位置,并且这种方式得到的光照信息也是正确的(并不是简简单单的平移图像)

局限:

分辨率不足,光场相机的每个像素都相当于要记录一个像素组,在同样的胶片尺寸下,光场相机的分辨率往往会很低

成本高、难设计,对仪器的精密程度大大提高,就比如微透镜组

Color

人类视网膜上有三种感知色彩的视锥细胞,所以理论上我们用三种颜色的光就可以混合出自然界中任何一种颜色来

色匹配函数

CIE-RGB空间 红色曲线部分地方出现的负值

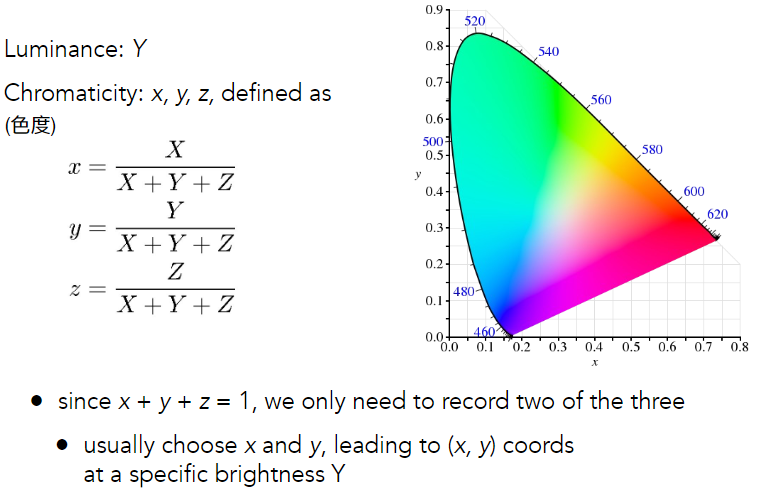

CIE-XYZ空间 CIE-RGB线性变换都为正 完全等价

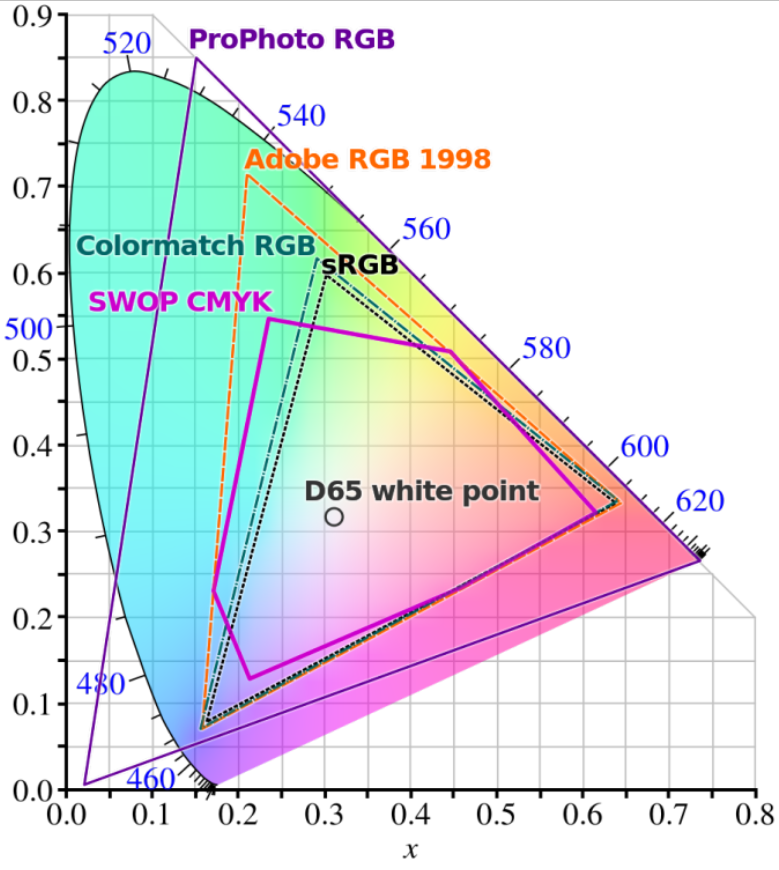

色域&屏幕色彩空间

三维参数降至二维,通过归一化使三个参数的和为1,这时候就只需要两个参数(也要固定一个值)就能表示颜色空间中任意一个颜色了,而这种表示方式所得到的颜色集合,我们就称之为色域

计算机屏幕并不是人眼,他所支持的色域通常会比可见光色域小得多,必须把计算得到的 XYZ 转换到屏幕空间中(空间变换和gamma校正),而因为不同设备的转码方式不同,就形成了不同设备各自的色彩空间

色彩空间: https://zhuanlan.zhihu.com/p/24214731

gamma矫正:

从Radiance到颜色,不是简单线性变换就能得到的,因为显示器上颜色显示是非线性的,必须要矫正过

https://zhuanlan.zhihu.com/p/36581276

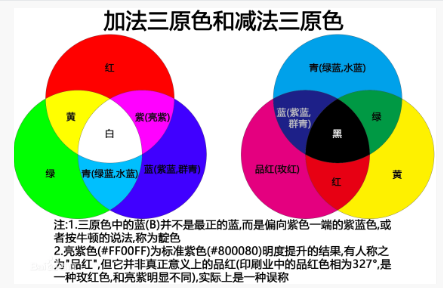

光学三原色和绘画三原色是不一样的,光学三原色是红绿蓝rgb,美术三原色是品红,黄和靛青

光学三原色是加色模型,美术三原色是减色模型